GTC2016 自動運転まとめ

(部分引用)

自動運転は2020年代に急速に普及するとされ、CUDA(クーダ)を利用したソフトウェアとNVIDIAのGPUを組み合わせたAIは、切り札になると注目を集めている。

自動車事業 上級部長のダニー・シャピーロ氏に話を伺った。実際に自動車メーカーとのやりとりなどをする同社の自動車事業のキーパーソンだ。

〇AIによる自動運転を、自動車からクラウドまで一気通貫にソリューションを提供するNVIDIA

シャピーロ氏は「自動車は急速に進化している。このため、弊社も従来はIVIやグラフィックスなどに注力してきたが、現在はAIによる自動運転車の実現に注力している。弊社はOEMパートナーと共に、トランスポーテーションを変えていきたい。

自動車はこれまでよりもより安全で、より効率が向上し、社会にとって有益なモノになると考えている」と述べ、自動運転の技術が自動車をより安全な乗り物に進化させ、物流などを含めて交通システムを進化させていきたいとした。

「米国では自動運転が日々ニュースになっている。日本でも同じような状況だと思うが、自動運転は水面下で開発されいるような技術ではなくて、みなの目につくところで開発が進んでいる。そこには自動車メーカーだけでなく、Googleのようなテクノロジー企業も参入しており、誰もがソリューションを必要としている、弊社はそれを提供する企業になりたいと思っている」

NVIDIAの方針としては、自動車メーカーであろうが、IT企業であろうが、自動運転の技術を実現する企業に向けて半導体やソフトウェアを提供する企業としてやっていきたいとした。

「多くの企業がGPUのパワーを認めている。ボルボ、フォード、ダイムラー、アウディなどの自動車メーカーとも研究開発を共同で行なっているが、そうしたメーカーが評価しているのは弊社がオープンアーキテクチャでやっていることだ。

GPUや基本的なソフトウェアや開発ツールなどは弊社から提供するが、各社の差別化要因となるアプリケーションは、各社がプログラミングして、使い勝手や品質などで競争することになる。

なぜなら顧客が自動車を購入する時にはそこを重視するからだ。NVIDIAは自動車メーカーに対して、1つのアーキテクチャで自動車からクラウドまでカバーできるプラットフォームを一気通貫で提供できることが他社に対しての強みになる」(シャピーロ氏)と述べた。

GPUでAIを実現する仕組みを自動車上だけでなく、クラウド、そして開発者の開発環境を含めて提供することができていることがNVIDIAの強みだと説明した。

AIで実現される自動運転は、自動車だけがAIになっても実現することができない。自動車と同時にクラウドにあるサーバーにもAIが展開され、双方向で通信が行なわれてシステムとして動作する。

そして、そのAIを実現するのが、ディープラーニングというコンピューティングモデルで、そのディープラーニングで最も高い処理能力を現在のところ実現しているのがNVIDIAのGPU、そしてそれを汎用コンピューティングに使う仕組みであるCUDAなのだ。

NVIDIAはCUDAを自動車向けの半導体であるTegraでも提供しており、クラウドサーバー向けのGPUであるTeslaも、開発に利用するPCで利用されるGeForceやQuadroでも利用できるようにしている。

そのように、自動車、開発用PC、サーバーのすべて同じCUDAによるAIのプラットフォームを提供できるのがNVIDIAの強みなのだ。

NVIDIAはソリューションを提供し、自動車メーカーがアプリケーションを作り独自性を出す

Q:ボッシュなどのティアワンの部品メーカーは、AIによる自動運転より前に、ASICとレーダーなどを組み合わせた自動運転にも取り組んでいる。それらに比べてAIのアドバンテージは?

シャピーロ氏:ティアワンの部品メーカーは弊社にとっての競合ではなくパートナーだ。重要な事は、今日の基調講演で弊社のCEOが言っていたように、GPUは頭脳になるということだ。

このため、固定機能のASICなどに比べて電力比性能や、性能そのものの観点で有利だ。半導体に固定の機能を持たせることは、非常に複雑にならざるをえないが、自動運転の技術は非常に早いペースで進化しており、常に機能をアップグレードしていく必要がある。

そうした時にディープラーニングを活用したAIを利用することで、機能を簡単に進化させていくことができる。自動運転の進むべき正しい路はAIだと弊社では考えている。

Q:ASICと比較した場合のコストはどうなのか?

シャピーロ氏:弊社では価格モデルについては公表していない。しかし、いくつかのヒントはお話したいと思う。現在の自動車はたくさんのECUが搭載されている。しかし、それを少ないGPUで実現していけば、多数のECUを搭載する場合に比べて部材のコストを下げることができるし、かつ開発コストも下げることができる。

そのように考えれば、GPUによるAIの自動運転は決してコストが高いということはないと思う。

Q:例えばMobileyeのような画像認識のベンダーは御社にとっての競合なのか?

シャピーロ氏:競合しているとも言えるし、そうでないとも言える。イメージ認識の性能という意味では、ディープラーニングを利用したAIがコンピュータビジョン(CV)よりも圧倒的に強力だ。ただ、現在この市場はまだ立ち上がったばかりで、弊社以外に誰もAIのスーパーコンピュータを作れていない。

このため、他の半導体メーカーなどはそうした技術をもった他の企業を買収することに一生懸命になっている。

Mobileyeの例で言えば、アウディのzFASはMobileyeのCVとNVIDIAのGPUを組み合わせている。従って、競合ではあるが、そのように一緒に自動車の中に入っているという例もある。ただ、アウディの例で言えば、アウディが2年間開発してきたCVの画像認識を、弊社のAIを利用して4時間学習したところ4時間で簡単に実現した。このように、AIはこれまでの常識を大きく変える可能性を秘めている。

Q:自動車に搭載する場合は、機能安全を実現するために、フェールセーフ、故障診断などを実現する必要があると思うが?

シャピーロ氏:本日の弊社CEOの基調講演で説明された次世代SoCとなるXavierではASIL CレベルないしはISO26262に対応した機能安全を実現している。自動車メーカーでは、例えばボルボがブレーキとステアリングで冗長性を実現しているが、おそらく自動運転を実現する際にはSoCや基板を2つ搭載するなどの仕組みになっていくと思う。

Q:今後自動車はどのようなものを検知していくことになると思うか?

シャピーロ氏:弊社では自動車を作っていないので、今後自動車メーカーがどのような選択をするかを答える立場にはない。弊社がやりたいのは自動車のシステムを作り、それを提供していくということだ。例えば、基調講演で紹介した、BB8は3000マイルを運転しただけであそこまでのことができるようになった。

AIで大事なことはどれだけの距離を走らせたかではなく、どんな内容の距離を走らせたかにある。

現在はシミュレーション技術も進んでおり、潜在的に危険なシチュエーションを人間が運転するよりも遙かに安全に運転できる。そうした技術が進んだ飛行機では、今でも事故はないわけではないが昔に比べればはるかに少なくなっている。

Q:トロリー(トロッコ)問題(ある人を助けるために他の人を犠牲にするのは許されるのか?という論題)についてはどのように思うか?

シャピーロ氏:非常に難しい問題だが、自動車メーカーにとって重要な事はいかようにもプログラミングできるということを指摘しておきたい。自動車メーカーができるだけ優れたプログラムを作ることで、人が生きるの死ぬという事故を避けることができる。

自動車メーカーはプログラムをできるだけ保守的に作ることで事故を防げるし、AIのドライバーはスピード違反もしないし、お酒も飲まないし、怒りにまかせて運転したりもしない。例えば、がんに効く薬ができたとして、9割には効くが、1割には効かないという薬ができたら、社会は当然導入を検討すると思う。自動運転もそれと同じ議論ではないだろうか。

Q:米国で発生したテスラ・モータースの自動運転車の事故についてはどのように思われるか?

シャピーロ氏:大変悲劇的なことだ。現在の自動運転車は成長性のあるものではなく、ADASがそこをカバーしきることができなかった。もっと処理能力が高いコンピューターで、センサーがもっとあれば防げたかもしれない。

ただし、そのテスラの事故が起きた同じ日に全米で95人の方が自動車事故で亡くなられている。自動運転による事故ということで大きく取り上げられているが、交通事故全体から考えれば小さな割合でしかない。この事故から教訓を引き出すとすれば、メーカーはよく消費者とコミュニケーションを取らなければならない、そういうことではないか。

Q:Xavierについて詳細を教えてほしい。

シャピーロ氏:DRIVE PX2の最上位モデルとなる2つのParkerと、2つのPascalで実現している性能が、1つのXavierで実現することが可能になり、かつ消費電力は1/4になる。もちろんそれに合わせて価格も安くすることが可能になるだろう。

Q:NVIDIAのプラットフォームを採用したら、どの自動車も同じような製品になってしまうのではないか?

シャピーロ氏:決してそうではない。自動車メーカーは既に自動車そのものではなく、自動車という体験を販売している。ブランドは安全性、スムーズなドライバビリティ、使いやすいデジタル機器など複数の体験を代弁している。

自動車メーカーはそうしたところを決して他の会社にアウトソースすることはない。我々が提供しているのはあくまでプラットフォームであり、GPU、ソフトウェア、ライブラリなどであり、それらを利用して自動車メーカーが自分自身でアプリケーションを作成して独自のユーザー体験をユーザーに提供していく、それはこれまでと何も変わらないと我々は考えている。

(部分引用)

ダニー・シャピーロ(Danny Shapiro)氏に単独インタビューを行い、実用化に向け加速する同社の自動運転プラットフォーム戦略について話を聞いた。

(聞き手:三浦和也)

----:「GTC Japan 2014」にてインタビューさせていただいた際は、Tegraプロセッサをアウディ車に搭載し、ADAS(先進運転支援システム)が普及していくという話でした。

2015年のCESくらいからニューラルネットワークやディープラーニングについて話し始めています。AIの取り組みよりも先にNVIDIAさんは自動車への取り組みを行っていたことになりますが、それはコンピューティングの変化がAIをもたらしたのか、それとも自動車への取り組みがAIを求めたのでしょうか。

ダニー・シャピーロ氏(以下敬称略):自動車業界からそういったニーズがあったのが大きいですね。ニーズは常にありましたが、現状の規模での実装ができていないとあまり意味がなかったため、最近まではそれが具現化していなかったのです。

例えば自動車メーカーと協業した場合、試作車のトランクいっぱいにモジュールを乗せていました。そこで、私どもの「Drive PX」が初めて、きちんと自動車業界のニーズを満たすパフォーマンスを実現したうえで、車で実装できるだけの小ささを実現した初めてのソリューションでないかと考えています。

ディープラーニングに関しては、ニューヨークタイムズをはじめとした一般記事を扱うメディア媒体でもここ数年くらい多く話題にあがっていますが、ここまでビッグデータにアクセスができるようになったという理由のほかに、やはりGPUの存在が一番大きいのではないかと感じています。

弊社CEOのジェンスンによる基調講演でも述べましたが、GPUの持っている並行処理能力がディープラーニングを加速させているのです。例えば時には2カ月でかかっていた分析がものの1日で終わってしまうだとか、そういったスピードアップが大きいと思います。

----:AIが人間の知能を超えるシンギュラリティが2045年に起こると言われていますが、NVIDIAが自動車に関して起こるシンギュラリティは何年だと思いますか。

シャピーロ:実は私はそのようなことは気にしていないのです。私どもが目の当たりにしているのは、システムなりコンピューターが、一定の分野においては人間を超えるような能力を得るよう学ばせることができるというもので、これが急激に加速しているのだと思います。コンピューターでの超人的なレベルのものと、自由な発想でのイノベーションでは、やはり少し趣が異なるのではないでしょうか。

つまり、私どものゴールは、自分で考えることができる車を開発することではなく、あくまでも人間の運転者をはるかに卓越するパフォーマンスを持ち、一定の情報に基づいて適切な判断をできるようにさせることです。

しかし、それは自分で考えるというよりはインプットされた情報に基づいて判断を行うための仕組みだと考えています。そういった意味では、より良い判断をさせるかの部分で存在意義・価値のあるプラットフォームということですね。

データが重要なシステムとなりますので、必要なデータをできる限りシステムに取り込ませるためのセンサーや、もう一つのレイヤーとして地図データも活用します。

V2Xによる、路面、車同士のやり取りなど、それらのデータをすべて集約して適格な判断ができるようにしているのです。例えばセンサーによる対向車への判断で重要になってくるものの一つとしては、このあとどちらに曲がるのかという情報を、車両間の通信で対向車からデータをとるという方法もあります。

天候の情報やその時の交通状況、路面の状態など、そういった情報すべてを集約してシステムに取り込むことができれば、より確実な情報のインフォームドディシジョンを実現することができます。

◆NVIDIAの「BB8」から見えた普及への課題

----:ジェンスン氏の基調講演では、実証試験用車の「BB8」が非常に興味深かったです。これまで学習にAIを活用していくというのはありましたが、答えをAIが出して走らせるという、2つのAIを作用させるのには驚かされました。そのBB8のコンセプトについて教えてください。

シャピーロ:BB8は、まだ研究開発段階の試作車です。大量生産に移して世にあふれ出るいろんな問題を解決するものではありません。なぜBB8を開発したかについては、AIを、特にディープニューラルネットワークを様々な形で自動車の運転に役立てることができるということを皆さんにお見せしたかったというのがコンセプトです。

ディープラーニングを使ったニューラルネットワークは非常にパワフルな存在で、例えばiPhoneのSiriのように音声認識に合わせてパーソナルアシスタンス的な役割を担うこともできますし、実は医学の世界でがん細胞を発見するための機能を果たしてもいます。

自動車の世界であれば、歩行車を正確に見分けるといったこともできます。計算能力がここまで進化したことによってそういったことができ、データを認識することによってその中にパターンを見出すのです。

それが音声、センサーでとってきたデータ、あるいはX線写真でも、そういったすべてのデータを社内で様々なニューラルネットワークを使いわけ、あらゆるデータを取り込み、様々な分析方法を通し、それを再統合することによって信頼性の高いテクノロジーを築き上げることができます。

BB8の学習にあたっては様々な要素を学ばせています。交通標識や歩行者がどういったものかを学ばせることはできますが、私どもがとったアプローチでは、見ているもの全景をピクセルとして捉え、そこで読み取ったデータからハンドルの操作角度を判断します。

全景をピクセルで捉えることは漠然としたものになるのではと思われるかもしれませんが、コンピューターであればそれは問題ない部分なのです。それを正確にデータとして捉えることができれば、正確な判断ができるというコンセプトなのです。

実は、BB8自体は周りに他の車がいるとか歩行者や人がいるなんてことをわかっていないのです。周囲の存在すべてを捉えた上で、こちらの方向だと運転しても大丈夫だとという判断をします。

それぞれの要素は認識していないものの、自分が行くべき方向が分かるようになっているということです。何がすごいかというと、プログラミングを加えたり修正をしたりすることなく、迂回ルートへの変更も自動で判断できるようになっています。

BB8はあくまで研究段階の試作車なので問題はありませんが、実際に商品として消費者のもとに届けるには、様々なニューラルネットワークを組み合わせなければいけません。

先ほど言ったのは「OpenroadNet」という仕組みですが、それに加え、「DriveNet」という前を歩行者が横切ったら認識して車を止めるための仕組みなど、そういったものを組み合わせて使っていかないと商業化、商用化は難しいと考えています。

----:ルールを自動運転にプログラムし、そこにAIによる判断を追加するということでしょうか。

シャピーロ:そこも自動車メーカーによってコンセプトは様々ですが、基本的には何らかのルールは設定することにはなります。速度制限といった交通法規を守って走るのはルールですから。

日本でも追い越し禁止車線では、基本的には対向側の車線にでて追い越ししてはいけませんが、前の車が止まっていた場合は周りを迂回できるようにしなければなりません。

そこも人間の運転をきちんと再現するために、ルールに対する例外は入れておくことになると思います。人間であればその場で判断して迂回できるのに、自動運転車は前の車が動くまで一日中待っているというような状態にはしたくありません。

そういった場合の判断のプログラミングされるものは、安全運転をしている人間のドライバーであればどういった動作をとるか、きちんと安全を確認した上で適切な行動がとれるかといったものになるかと思います。

ダニー・シャピーロ氏

----:例外となるような人々の経験もニューラルネットワークの中で積みかなさなっていくと。

シャピーロ:基本的にはその通りですが、すべての人の運転経験を蓄積してAIに押し込むのではなく、プロフェッショナルなドライバーが運転した動作を積み上げていくのです。

何台もの車からデータを収集してクラウドに入れてそのまま処理させるのではなく、人間のデータサイエンティストがニューラルネットワークで学んだデータを適切に検証した上で、出来上がったものを現実世界の車に還元していきます。

そのやり方であれば常にアップデートをかけることができますし、さらに機能を向上させていくことが可能でしょう。

◆自動運転実現に向けたNVIDIAのテクノロジーとは

----:日本でも発表された「Xavier」は次世代の「Drive PX」となるのでしょうか。もしくは上位版の位置づけでしょうか。

シャピーロ:実際に市場に投入できるまでには1年以上かかりますので、そういう意味では次世代チップと捉えていただいていいと思います。2週間前にアナウンスしたばかりのものですが、一番のポイントは、現行の大型なシステムで開発を進めておいて、実際に商用でリリースする際にはサイズがさらに小さくなった形で出せるということです。

新しい商用化に耐えうるようなチップが出てくるのを待つのではなく、出てくるという前提で今から開発を進め、そのチップが出てきたらそれに合わせてローンチできる、というやり方です。Xavierに関しては、自動車業界と継続的にやり取りをしていますので、自動車OEMメーカーのニーズをきちんと取り込んだ上でオートモーティブグレードのチップを実現していきたいと考えています。

Xavierは現在3つあるSoCの中で、4基のプロセッサを積んだ最上位のものと同等のパフォーマンスを実現しながら、電力消費は4分の1に抑えています。

----:「AutoCruise」はまた違うものなのでしょうか。

シャピーロ:「AutoCruise」には幅広い機能が入ってきます。運転者に警告を出すといった、レベルとしては高くない自動運転の初歩的な仕組みですね。しかし、それにはADASをはるかに超える機能が入っていますし、膨大な計算能力が必要になります。

アーキテクチャは拡張性高くデザインした上で、まずは4プロセッサバージョンを出し、後々スケールダウンして電力消費を抑えるなどローコスト化を図ることができます。

完全な自動運転を実現するだけのデータインプットが提供できないにしても、オートクルーズレベルは可能にできるという、そういった考え方のものです。私たちは特定の自動車メーカー専用として開発しているわけではなく、オープンプラットフォームとして開発をしています。

ですので、会社によっては、同じ弊社のソフトウェアを使っていても高速道路向けのオートクルーズのものにするかもしれませんし、街乗りの際の自動運転にするかもしれない。また、完全な自律運転のものを考える会社もあると思います。

基本的にはそういった使い方のソフトウェアですし、継続的にアップデートも行っていきます。どんどん使える機能をアップデートして提供していくという、スマホのアプリをより良くアップデートしていくのと同じ感覚ですね。

----:「Drive PX 2」のI/Oは共通化されたものなのでしょうか。

シャピーロ:基本的に自動車用ワイヤーハーネスのコードが接続できます。ジョイント式のタイプなので、様々なインプットを入れることが可能です。

現状としてはハーネス用の設計ですので、自動車メーカーやTeir1の部品メーカーが少し改良して使うということはあり得ると思います。

----:リファレンスモデルとなるのでしょうか。

シャピーロ:正確にはNVIDIAで製造しているわけではなく、チップもTSMCにOEMでお願いしているものです。私たちは、アウディやBMW、ホンダといったお客様と相談をしながら、各社とお付き合いのあるTier1の部品メーカーへのアドバイスを差し上げるようにしています。

----:PC向けのグラフィックボードのように、モジュールを差し替えて使うことは可能なのでしょうか。

シャピーロ:そこまで標準化が進めば願ったり叶ったりです。WindowsのマシンのPCI Expressのように、モジュールをプラグイン/アウトで抜き差しできるようなところまで行きつけばよいのですが。

自動車メーカーはそこまでは行っておらず、各社独自でカスタマイズはしている状況です。例えば車載インフォテイメントですと、ビジュアルコンピューティングモジュールを5年前に発表しており、アウディやテスラに使っていただいてますが、ソフトウェアとOSはバラバラなのが現状です。

----:「DriveWorks」もリファレンス的な発想なのでしょうか。

シャピーロ:ゲーム業界に置き換えると話が見えやすくなると思います。例えばNVIDIAはビデオゲーム自体の開発は行っていません。提供しているのは、ハードウェアやソフトウェアのドライバ、開発者がスムーズに開発を進めるためのミドルウェアやライブラリ、レンダリングエンジン、物理エンジン、そういったものをゲーム業界向けに提供しています。

流体設計をする際に、NVIDIAのレンダリングテクノロジー、物理演算技術を使っていただければ、ゲームタイトルごとに1から開発する必要はありません。

ゲーム業界に提供しているそういったツールやソリューションが「NVIDIA GameWorks」という形でパッケージになっています。

要は「GameWorks」を使ってゲームデベロッパーが素晴らしいゲームを開発しているのです。

自動運転に関しても全く同じビジネスモデルで考えており、NVIDIAが提供するのはスーパーコンピュータープラットフォームと「DriveWorks」というソフトウェアの部分です。それを使って、各自動車会社が自動運転用のアプリケーションを独自で開発していただき、NVIDIAが提供するアルゴリズムであったりライブラリであったりディープニューラルネットワークを活用できるのです。

NVIDIAとしてはどれも提供することが可能ですが、自動車メーカーも差別化を図りたいという思惑があると思いますので、当然アプリケーションは各社独自で開発できますし、アルゴリズムを独自のもので組み上げたり、ニューラルネットワークも独自のものを使用したりできます。

またテクノロジーの観点からは、ADASやセンサーだけでは足りず、さらに多様なセンサーを通じてデータを収集した上で、より高度な計算能力で状況判断を行っていかないと、自動運転としては完全ではありません。

事故を起こした、テスラの車が積んでいたスマートカメラはアップデートできないことも問題点としてあったと考えています。

例えば目の前でトラックが幅寄せしてハンドルを切るなど、種々の動作に対してソフトウェアアップデートで対応していくことが可能となるからです。

(部分引用)

自動車領域のセッションでは東京大学 大学院 情報理工学系研究科 准教授(ティアフォー 取締役)の加藤真平氏が、「自動運転とGPGPU」と題して完全自動運転の研究開発用として公開しているオープンソース ソフトウェア「Autoware」などについて話した。

AutowareはLinuxとROSをベースに、市街地一般道における完全自動運転に必要となる認知、判断、操作の機能を備えた自動運転システム用オープンソースソフトウェア。

講演ではまず、加藤氏が「いつまでも実証実験をしているわけにはいかない」と現時点での自動運転に対する考えを述べるとともに、実証実験の次の段階として50~60km/hで自動運転する乗り物をライドシェアや高齢者の多い交通不便地域におけるモビリティサービスとして活用できないか、といった観点で活動を進めていることを明かした。

さらに、そういった活動をグローバル展開するにあたってはプラットフォームをオープン化することで立ち上げの時間を節約してもらい、より多くの人に自動運転に参入してもらう狙いがあることを示した。

加藤氏は「今のGPUの性能はひと昔前のスパコンとほぼ同じ性能で、この十数年で大きな進化を遂げている。将来的にはワンチップ化され、人間に近い認識機能で自動運転するシステムが実現できるかもしれない」との見方を示した。

また、実際にGPUをどのように自動運転に活用しているかについて、画像認識の処理に活用していることを紹介、「CPUで1秒ぐらい処理にかかるものが、GPUを使うことで10~20倍以上速く処理をでき、実際のサービスで想定しているスピード感で実験することができる」と話し、「製品のロードマップがあることで、我々も研究を進めるうえで安心感がある」との感想を話した。

画像認識の活用方法に関しては、信号の認識については3D地図との組み合わせで信号のあるポイントだけ抽出することや、画像で認識したクルマに対して車両の向きに合わせた物理法則を条件付けるなど、効率的な処理方法を紹介した。

一方、ディープラーニングの活用について加藤氏は「例えば(障害物となる)前走車に対して、ブレーキをかけて止めるのか、ブレーキを使わずによけて通過するのか、この判断は非常に難しい」と話し、これら複雑な状況の判断を求められる場合に向けて、現在は自動車教習所の教官によるたくさんの走行データを集めるなど、ディープラーニングを活用しているという。

最後に加藤氏は「自動運転は技術的には皆が同じことをやって、同じようなものができあがる。自動運転をどのように使うのかがビジネス上の差別化になる」との考えを示してセッションを締めくくった。

(部分引用)

レベル3の「Highway pilot」や自律駐車用のハードウエアやソフトウエアの最新技術を紹介。

Pascalの次の世代となるVoltaで2018年にSGEMM/Wの値を72まで向上させることを示した。

また、消費電力や小型化については、「DRIVE PX 2」で、2つのParker+2つのPascal GPUで構成するボードであったものから、次世代のXavierでは1つのSoCに変更、消費電力もDRIVE PX 2の80Wから、Xavierでは20Wに省電力化することなどを紹介した。

馬路氏は「消費電力は実に4分の1になり。ここまでくると、かなり高度な自動操縦が1つのアーキテクチャで実現できる」との見通しを示すとともに、車載向けAIスーパーコンピュータ SoCとなる「Xavier」の概要を紹介した。

Xavierは、GPU、ARMのCPUのほか、画像認識機能などを搭載したもので、馬路氏は「これぐらいのレベルがあれば、ドライバーなしの自動運転を十分できると思う」との考えを示すとともに「我々はディープラーニングに熟知しており、さらにスーパーコンピュータで超並列もできます。そういうものがすべて1つSoCに集約され、しかも20Wで自動操縦ができる状況がやってくる。ぜひ、我々と一緒に将来の自動操縦システムの開発を進めてほしい」とセッションを締めくくった。

(部分引用)

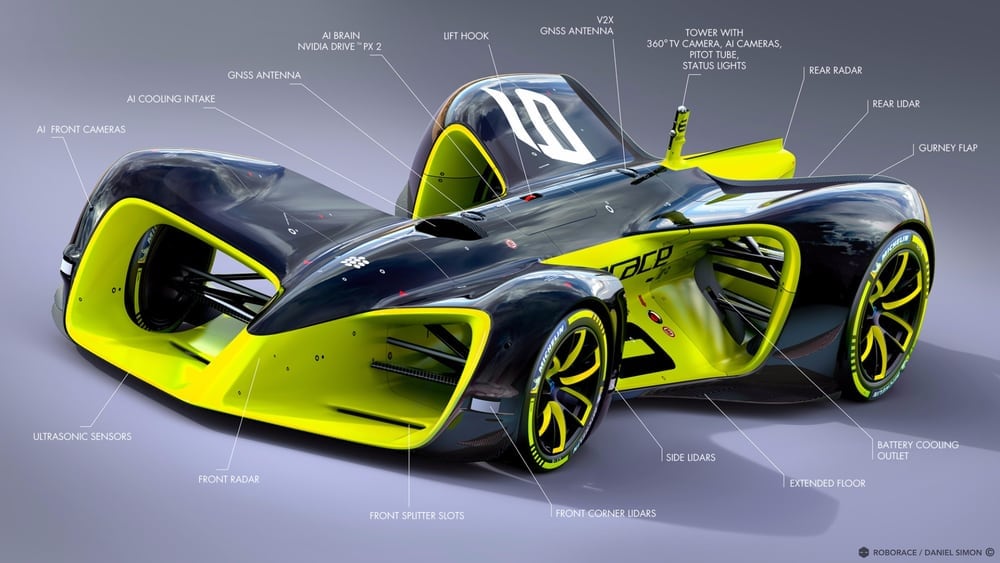

NVIDIAが2016年のCESで発表した車載人工知能エンジン「DRIVE PX 2」このセッションでは、DRIVE PX 2の構造、ソフトウェアスタックなど内部アーキテクチャについての解説が行なわれた。

DRIVE PX 2をNVIDIAはAIスーパーコンピュータと呼んでおり、クルマの自動運転を実現するための車載デバイスとしてデザインされている。DRIVE PX 2の前モデルとなるDRIVE PXは、車載用SoC(System On a Chip)「Tegra X1」を2基搭載し、12chのカメラ入力を持つなどディープラーニングによる映像認識を強く意識した製品だった。

新たなDRIVE PX 2では、GPUアーキテクチャ“Pascal”採用のGPU2基に加え、次世代型車載SoC「次世代Tegra」を2基搭載。それらにより車載モジュールとしてFP16で8TFLOPSの処理能力を獲得している。これは、現行世代のGPUアーキテクチャ“Maxwell”の処理ユニットを内蔵するTegra X1を2基搭載したDRIVE PXの4倍の処理能力となる。

なにより大きく変わったのが、新たにLiDARの入力を持ったことや水冷筐体になったこと。NVIDIAのジェンスン・フアンCEOは、このようになった理由を自動車メーカーの要望によるものがあると答えており、より負荷のかかる処理を自動車メーカーが望んでいるということだ。

消費電力も車載としては極めて大きい250Wとなっているが、これは開発段階に極力安定動作するよう水冷ユニットなどを装備したため。動作温度の安定化を狙ったものだろう。

最初に開発フローを紹介。NVIDIA DIGITSで学習し、学習結果をNVIDIA DRIVENETにポーティング。DRIVE PX 2で車載実行する。その結果を再びNVIDIA DIGITSで学習というようなものだ。

このDRIVE PX 2の持つI/O能力は70Gbit/sになるという。I/Oとして用意されているのは、GMSL Camera、CAN、GbE(Gigabit Ethernet)、HDMI、USBなどなど。

内部構造的には、2つの次世代TegraをGbEで接続。それぞれの次世代Tegraの内部にはPascalアーキテクチャの処理ユニットが搭載されており、その次世代Tegra内部のPascalとは別にPCI Express x4でPascal GPUを接続する。内蔵グラフィックスを持ちながら外付けビデオカードを搭載したPC 2台を、GbEで結んでクラスタが構築されている。

DRIVE PX 2のI/Oまわりは実際の開発環境に配慮されており、DRIVE PX 2で処理したデータを別途ログデータとして記録できるほか、RAWデータの記録も可能になっている。これにより、どのような映像をDRIVE PX 2がどのように判断したか後で検証することができ、開発サイクルの手助けになる。

ソフトウェア面ではNVIDIAの製品らしく豊富なツールを用意。デバッガーはもちろん、各GPUの負荷率なども分かり、ソフトウェアチューニングなどもできる。AUTOSARにも対応しており、AUTOSARとのつなぎ込みを行なうレイヤーについてはエレクトロビットが担当する。

この説明会の翌日、NVIDIA Pascal P110 GPUと、それを8基搭載する世界最速のスーパーコンピュータ「DGX-1」が発表された。DRIVE PX 2では一足先にPascalアーキテクチャのGPUが搭載されていたが、DGX-1が出たことによりPascalアーキテクチャでのソフトウェア開発サイクルが実現した。

各自動車会社が自動運転の1つの目標としているのが2020年。市販車への搭載を考慮すると1年~2年前にはある程度仕上がっている必要がある。そのようなタイムスケジュールを考えると、このPascalアーキテクチャによる自動運転車開発環境が本命となるのだろう。

【GTC 2016】自動運転の鍵を握る車載人工知能エンジン「DRIVE PX 2」のアーキテクチャを知る - Car Watch

(部分引用)

トヨタ自動車が1月に米国に設立したAI(人工知能)技術の研究・開発を行なう「Toyota Research Institute」(TRI)でCEOを務めるギル・プラット氏は、GPUソフトウェア開発者向け会議「GPU Technology Conference 2016」で4月7日11時(現地時間)から行なわれた今回のGTC3つめとなる基調講演に登壇。TRIが取り組んでいるAIの研究成果や、トヨタが考える自律運転/自動運転の方向性などに関する講演を行なった。

TRIはトヨタが1月に米国で設立したAIの研究開発を行なう企業。そのトップであるCEOに指名されたのは、ロボット技術の開発で著名なギル・プラット氏。

プラット氏はTRIをトヨタと共同で設立する以前は、米国の「DARPA(Defense Advanced Research Projects Agency:国防高等研究計画局)」という先進的軍事技術を開発する政府機関でロボット開発の責任者として基礎研究を行なっていた人物で、トヨタが“今後5年間で約10億ドル(日本円で約1100億円)を投入する”としてTRIを設立したときにCEOに就任して、トヨタが行なうAI研究開発を主導している。

プラット氏は「この地球上では120万人が1年間に交通事故で亡くなっており、非常に痛ましいことだ。そうした状況を少しでも改善していかなければならない」と述べ、交通事故の削減がTRIにとって大きなテーマであることを強調した。

次にプラット氏はAIの消費電力について言及。「現在のAIは非常に多くの電力、数千Wの電力を消費しないと動かすことができない。それに対して人間の脳はわずか30Wで動かすことができる」と述べ、AIが乗り越えるべき課題の1つとして消費電力があると指摘した。その解決策としては「もっと新しいハードウェアを導入し、演算を少なくし、複雑さを解消していく必要がある。また、必要のないときはOFFにするなど使い方も工夫していく必要がある」と述べ、ディープラーニングなどの新しいコンピューティングモデルを導入してより効率を高め、さらにより進んだ電力管理が重要だとした。

ディープラーニングによるAIのトレーニングに関する研究が昨年特に大きな進化を見せたことで、多くの自動車メーカーなどが自動運転、ないしは自律運転と呼ばれるAIによる運転の研究を進めている。

現在のロボット制御というのは、例えば無人偵察機などがそうであるように、ロボットがネットワークを経由してコントロールセンターの人間から制御を受ける形でコントロールされている。プラット氏は「今後もそうしたモデルでしかロボットは制御できないのか? 答えはノーだ。『Series』『Interleaved』『Parallel』の3つの方法がある」と述べ、自動制御のSeries、Interleaved、Parallelの3種類にそれぞれメリット、デメリットがあると説明した。

プラット氏によれば

Series は人間が指令を出し、それを受けて機械が動作するという仕組み。

Interleaved は2つの中間で人間とAIが半分ずつする方式。

Parallel は大人が子供をアシストするようにAIが人間をアシストする方式だという。

これをうまく受け入れていけば機械の動作も改善されていくとして、AIによるアシストを導入したロボットアームがより自然に動くDAPRAの実験動画などを公開した。

自動運転には2つのアプローチが考えられるとした。

1つはプラット氏が「Chauffer(運転手)/Series Autonomy」と呼ぶ、人間が命令を下し、AIがそれに応じて運転する方式(いわゆる自律運転)、

もう1つが「Guardian Angel(守護神)/Parallel Autonomy」と呼ぶAIがアシストする方式(いわゆる自動運転)。

それぞれにメリット、デメリットがあり、TRIとしてはどちらかだけにコミットメントするのではなく、両方を実装してドライバーが必要に応じて切り替えていく「Hybrid Autonomy」が正解だと考えていると説明した。

Chauffer(運転手)/Series AutonomyとGuardian Angel(守護神)/Parallel Autonomy

“ハイブリッド方式”の自動運転/自律運転を目指していく

その上でトヨタとNVIDIAの協業について触れ、トヨタがサッカー場ほどの敷地に建設しているシミュレーション装置の実現にNVIDIAが協力していることを紹介。人間の動作を再現して学習するマシンインターフェース、ソフトウェア開発、物理テストなどにNVIDIAが協力していると述べた。

講演の最後にプラット氏は、TRIが新たにミシガン州のアナーバーに第3の開発拠点を設立することを説明した。TRIはすでにパロ・アルトに自動運転の開発研究所を、そしてMIT(マサチューセツ工科大学)のあるケンブリッジにシミュレーションの開発研究所を構えている。

【GTC 2016】Toyota Research Institute CEO ギル・プラット氏の基調講演リポート - Car Watch